自分のPCで、Llama3を実行してみよう!

2024年4月19日にMetaでLlama3がリリースされました!

今回、公開されたモデルは8B、70Bの2種類です。

8B = パラメータが、80億個

128KサイズのTokenizerとGQA技法を使用して性能が向上したそうです。 今後400B以上のモデルも公開予定だそうで、性能が期待されます!

おそらく、私のPCでは難しいと思うので、久しぶりにハードウェアをアップグレードしたくなりますね。

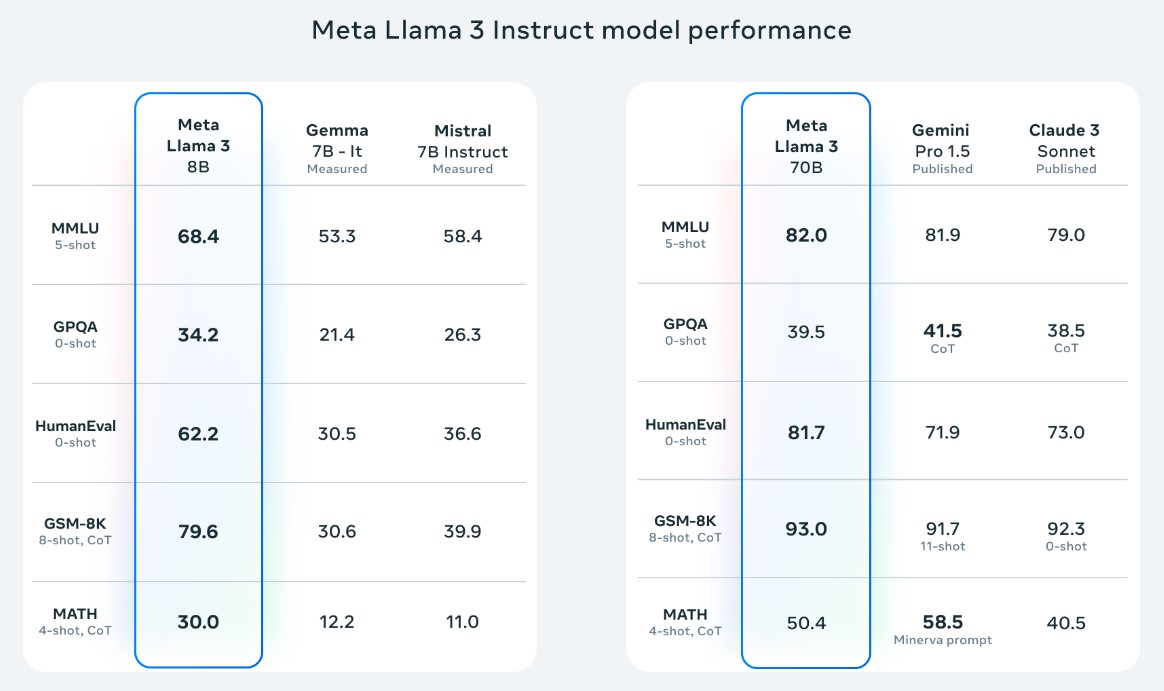

・Llama3の性能比較

もっと詳しく知りたい方は公式サイトで確認できます。

LLMモデルを実行させるための準備

すでに、AIに興味がある方は、Hugging Faceでモデルをダウンロードし、ターミナルやOllamaに上げて、使用していると思いますが、非専攻者の場合、意味の分からないターミナルやコーディングのハードルが高くて使えない方も多いと思います。

そのため、本ポスティングでは非専攻者でも、ターミナルやコーディング無しで、自分のPCのローカル環境でLlama3を動かすことを目指します。

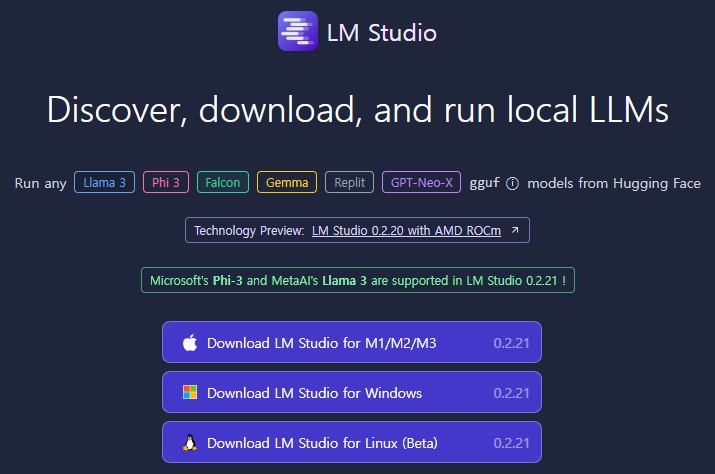

・⬇️LM Studio ダウンロード

LM Studioとは?

一般的な、ソフトウェアのように実行され、モデルを検索し、ダウンロードできるページも提供しています。

そのため、UI環境で簡単に自分が望むモデルをダウンロード及び実行して使用することが可能です!

Windows、Mac、Linuxに対応しているため、ほとんどのOSでも可能です。

公式サイトから、自分のOSに合わせてダウンロード後、インストールしてください!

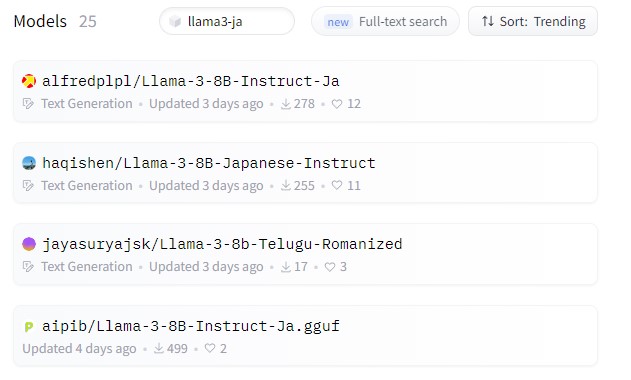

・🔎日本語が、学習されたLlama3モデル探し

日本語環境で、性能が優秀なAIを使うため、日本語学習がされているLlama3モデルを探してみます。

一般的に、AIモデルを探す時は HuggingFace を利用することになります。

HuggingFaceでLlma3-jpと検索すると、現在このような結果を確認できます。

ポスティング作成時点では、

25個モデルがありましたが、頻繁にアップロードされているので、結果が私と違うかもしれません!

https://huggingface.co/alfredplpl/Llama-3-8B-Instruct-Ja

https://huggingface.co/alfredplpl/Llama-3-8B-Instruct-Ja

私は、Trendingで、ソートした後、一番上のモデルを使用したいと思います。

Filesタブで、モデルを確認してみると、gguf拡張子のモデルがありませんでした。😓

GGUF(Georgi Gerganov Unified Format)とは、LLMモデルの保存形式で

GGML、GGUFなどがあります。

HuggingFaceで、もう少し探してみると、使用したいAlfredplplのモデルをggufに変換したモデルを見つけました!

直接変換も可能ですが、HuggingFaceに、すばやくアップロードされているので、まずはご希望のモデルを検索することをおすすめ🙇♂️

Alfredplpl-Llama-3-8B-Instruct-Ja-ggufの確認は、こちらへ

・🗜量子化レベル?

上記のリンクから、Fileタブを確認すると様々な形式のGGUFファイルが存在します。

ファイル名をよく見ると、Q1〜8などに分かれています、これは量子化レベルを表記したもので、簡単に説明すると、数字が小さいほど圧縮率が高くなります。

圧縮率が高いため、どうしても情報の損失が発生する可能性があり、性能低下が発生します。

逆に数字が大きいほど性能が良いということです!

しかし、容量も高くなるので、自分の状況に合わせて選んでください。

Q4 = 4-bit 量子化

Q8 = 8-bit 量子化

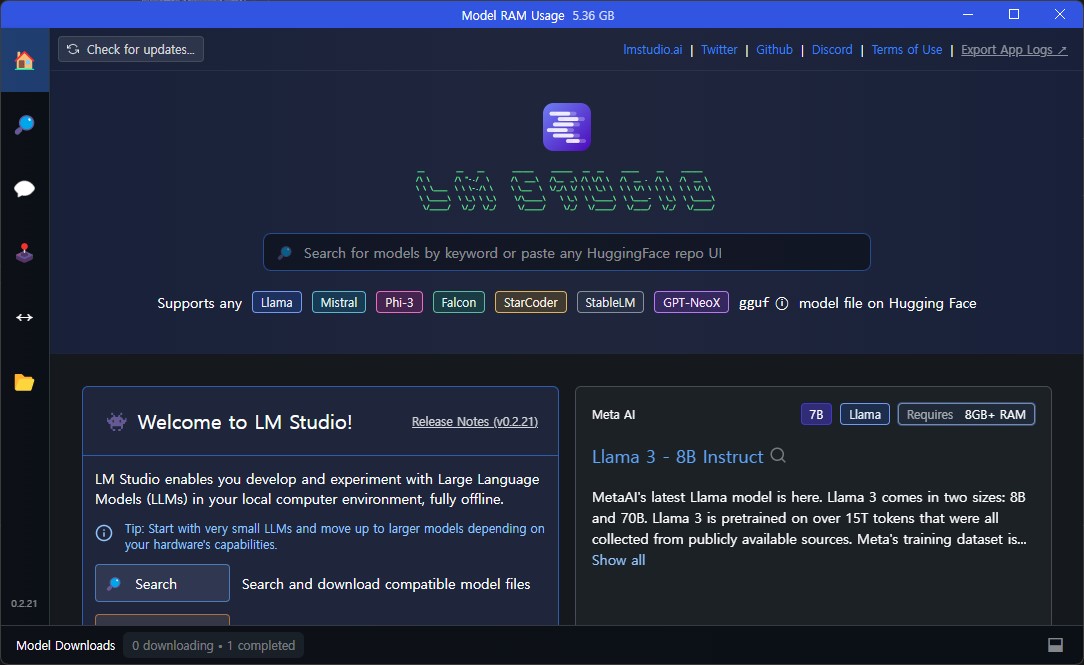

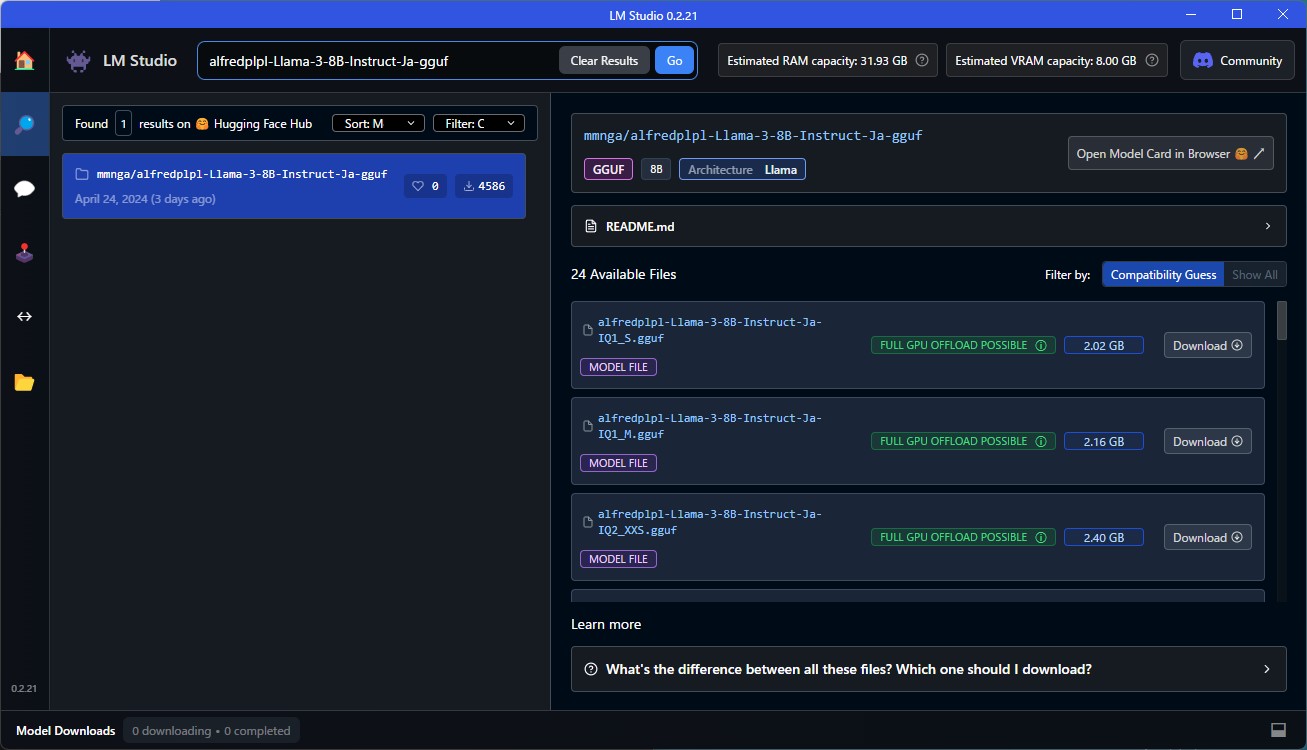

LM Studioで、モデルインストール

LM Studioを起動した後、左側のSearchタブに移動し、上記で見つけた alfredplpl-Llama-3-8B-Instruct-Ja-ggufを検索すると、そのリポジトリのGGUFモデルを全て確認ができます。

ご自身のPC仕様に合わせて、ダウンロードボタンをクリックして、ダウンロード及びインストールをしてください。

各モデルでこのような表示を確認することができますが、

緑色は、自分のpc仕様で動作が安定、青色は、動作しない可能性があることを示しています。

インストールが終わったら、左側メニューの

インストールが終わったら、左側メニューのMy Modelsで、現在インストールされているモデルをすべて確認することができます。

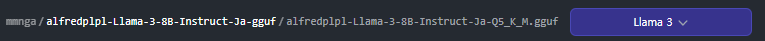

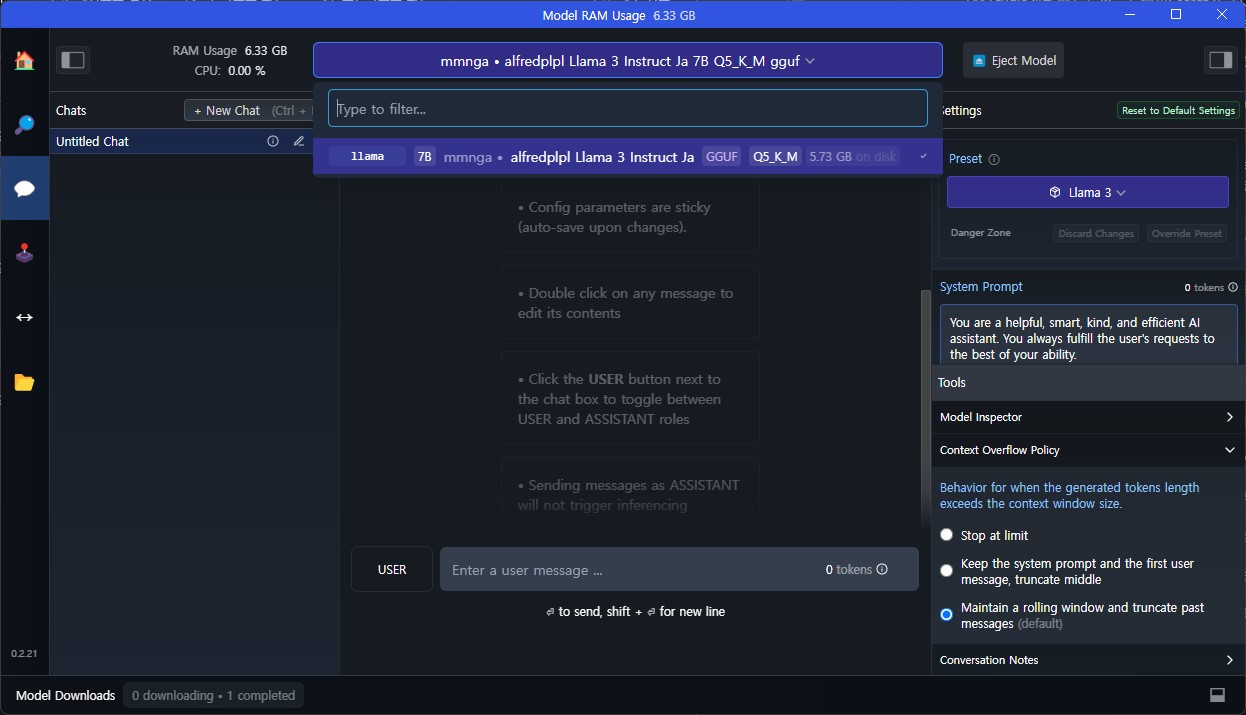

インストールされたモデルで、Default PresetをLlama3に設定すると、今後からも便利です!

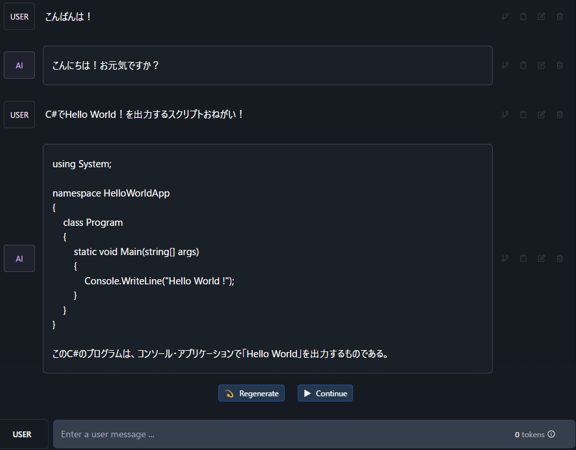

LM Studioで、AI Chatを利用

左側メニューのAI Chatに移動すると、ChatGPTと似たUIが出ます!

インストールしたモデルを選択し、PresetがLlama3であることを確認してから、使用することができます!🎉

個人的には、Presetをカスタムして使用しています。

Presetカスタムについては、需要者が多い場合、追加で作成します。🙇♂️

ChatGPTのように、トークンの心配なく気ままに使えるようになりましたね🙌

これで、非専攻者も自分のPCのローカル環境で、Llama3を使う方法を調べてみました!

お疲れ様でした!

(Tip) 個人的な使い方

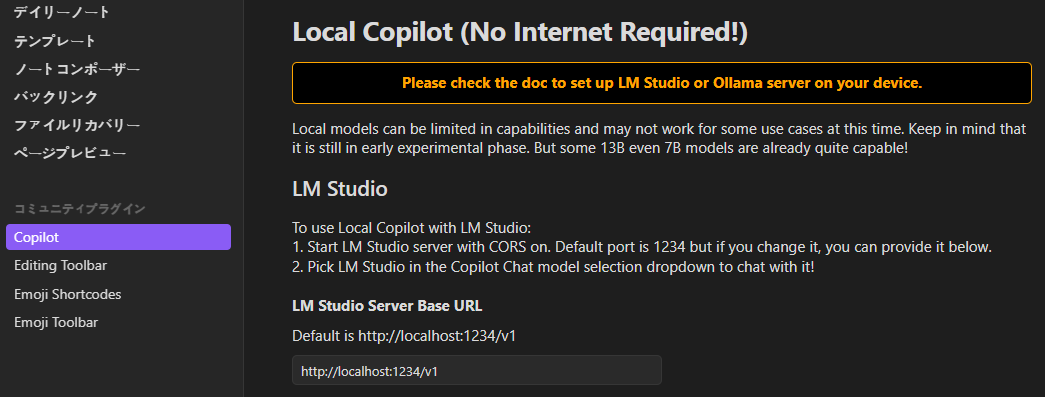

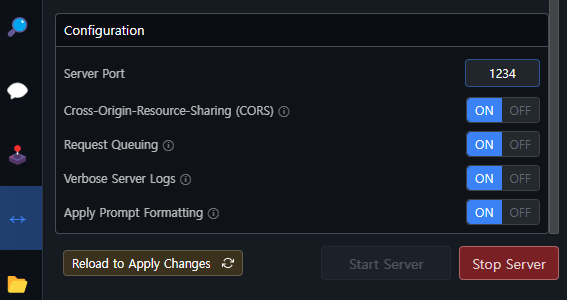

左側メニューにLocal Serverが、あります。

Local Serverでは、自分のPCをサーバーとして使用し、AIを使用することが可能です。

これを利用して、AIを利用したアプリを開発する時、有用に使っています。😆

・Obsidianをおすすめ!

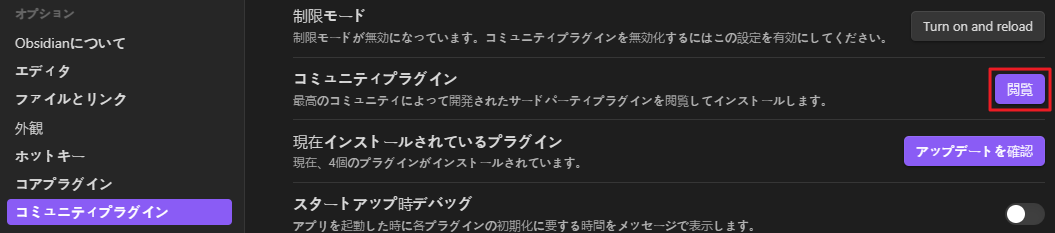

非開発者には、Obsidianをおすすめします!

Obsidianは、メモや文書作成などに便利ですのでお世話になっています。🙇♂️

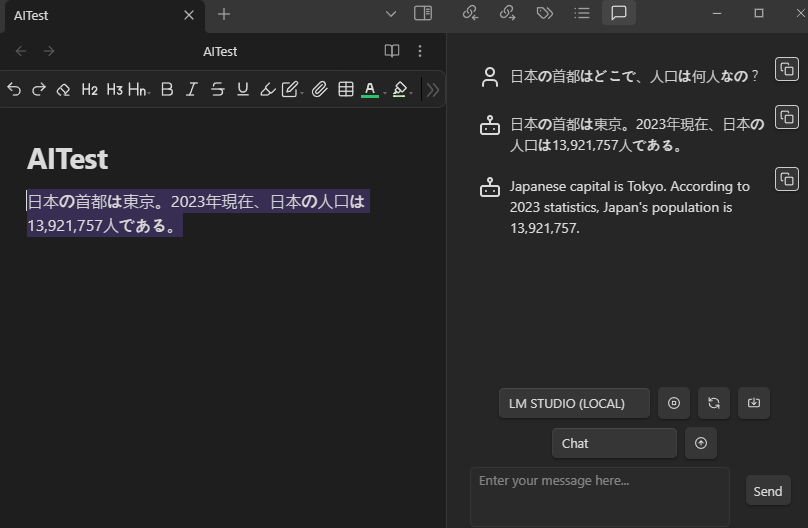

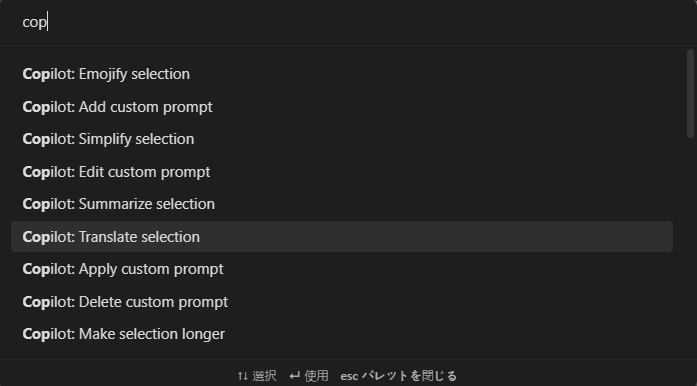

Obsidianに、Copilot Pluginをインストール後、LM StudioにインストールしたLlama3を連動してObsidian内部で、AIの使用が可能です。

・Obsidianに、Llama3連動

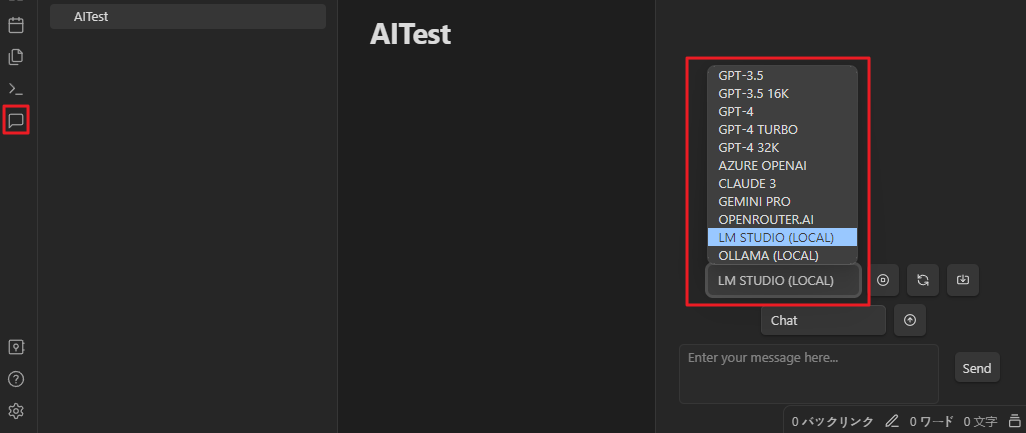

・ObsidianでAI Chatを利用してみよう

左側のCopilot Chatアイコンをクリックし、右側のCopilot Chatが開いたらLM STUDIOを選択して使用できます!

事前に、LMSTUDIOでサーバー実行が必須!

本ポスティングでは、詳しくは説明しないですが、このように文書を作成中AIが使えるようになりました!